感谢UniApi对本博客的的大力赞助。 创作不易,如果您觉得有帮助,请 支持LIncol29! 为了让我能够继续创作更好的内容,你也可以选择订阅博客的 VIP ,包年VIP仅需10元/年,所有VIP内容免费观看

前言

最近DeepSeek 非常火爆,为什么?与OpenAI的大模型相比,使用更少的花费和算力。训练出不逊色于OpenAI的大模型。孰强孰弱,一目了然。这也是过程AI大模型的崛起,但是目前Deep Seek官网挤爆了,各种前几天大火的第三方平台也接连崩溃。

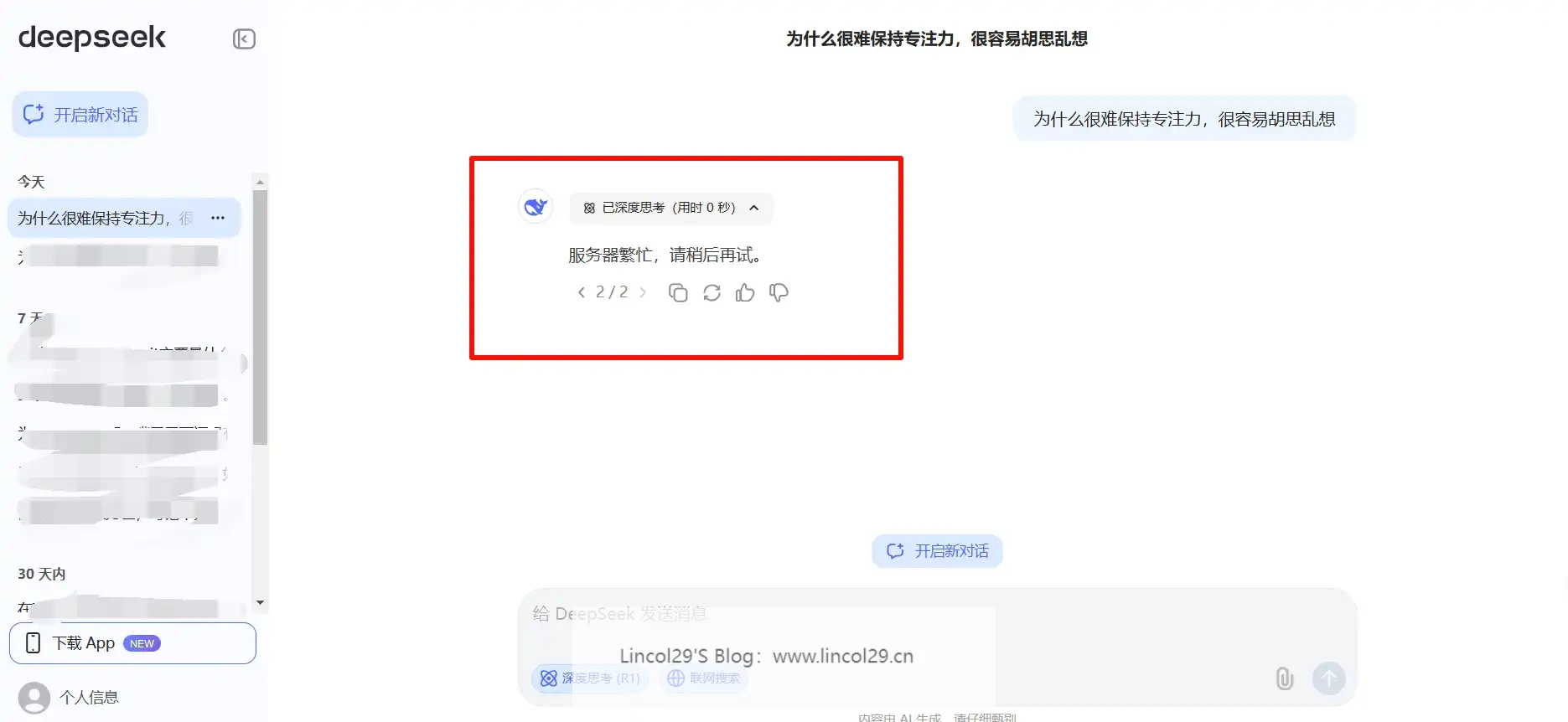

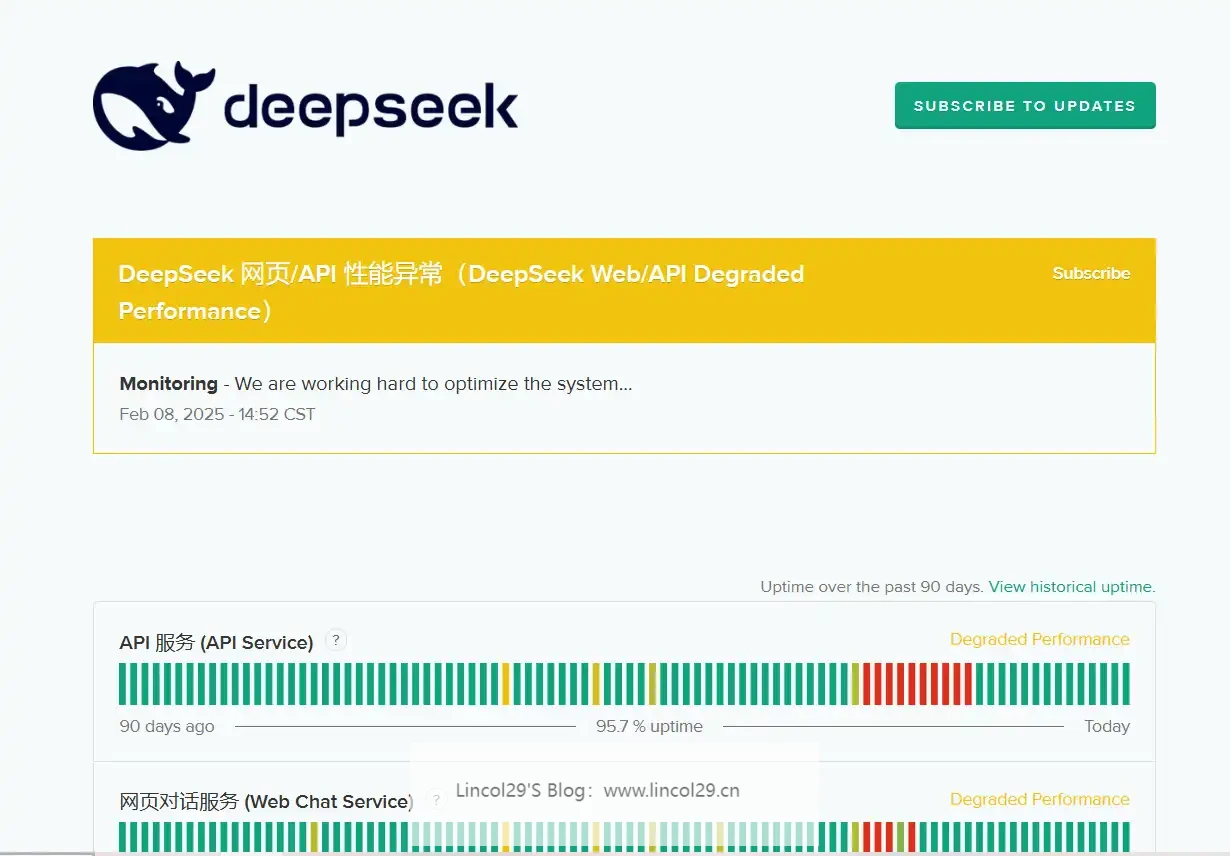

- Deep Seek官网服务器繁忙,API 也暂停充值。

- 本地机器性能无法部署 671B Deep Seek R1大模型,网上所谓的“满血”模型自卖自考

可以访问deepseek的状态监控网站,错开服务繁忙的时间

使用 AskManyAI

注册 AskManyAI

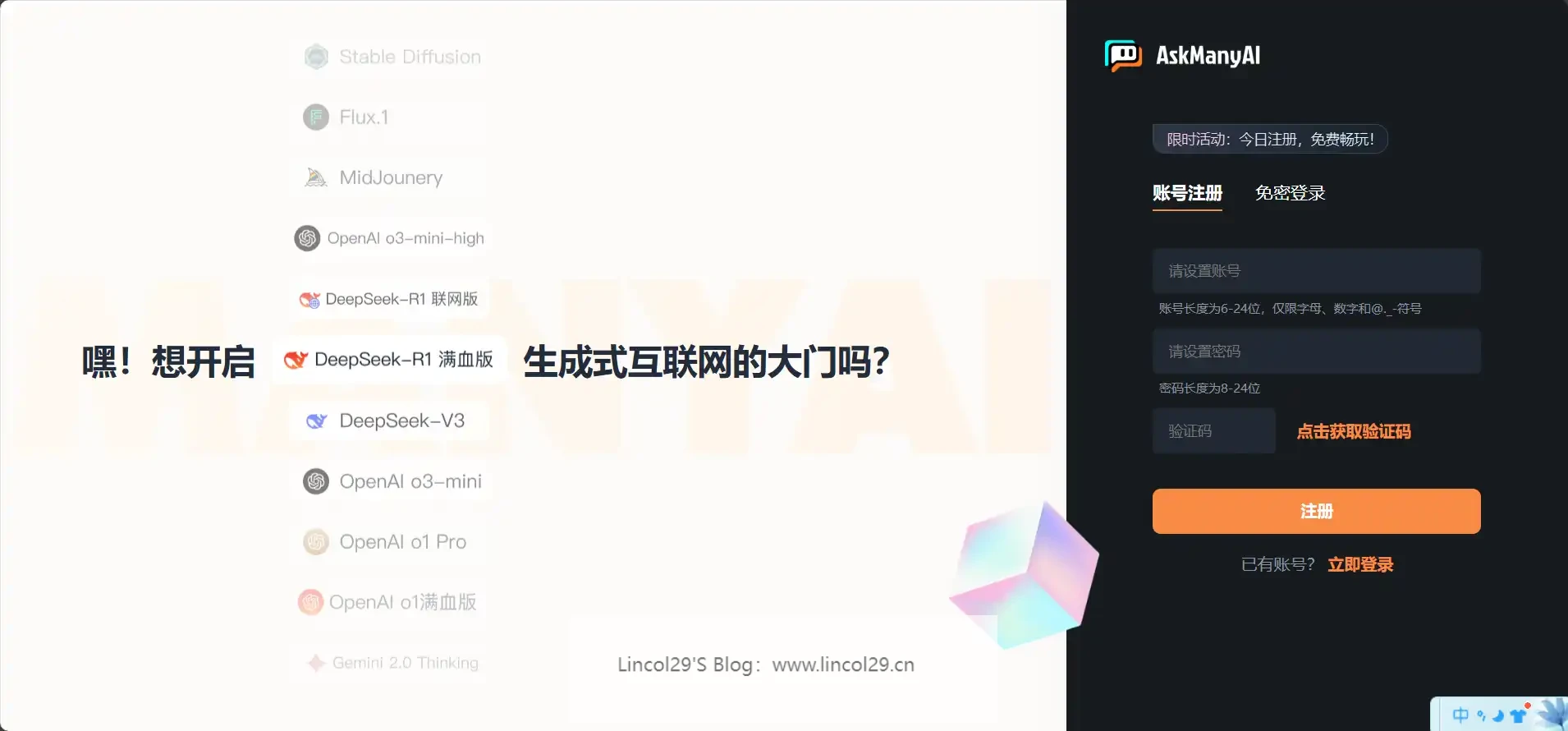

为了免费使用满血版 DeepSeek R1大模型,可以在AskManyAI平台注册使用(无广,无aff链)。

能够完全不卡顿使用联网 + 满血版 DeepSeek R1。

重点是:完全免费!

而且是全网独家的联网搜索 + 图片对话 + 文件上传全功能,回答速度也比市面其他产品快 N 多倍。

入口地址:

电脑浏览器或者手机浏览器都可以直接访问。

AskManyAI的注册登录页面

AskManyAi 使用指南

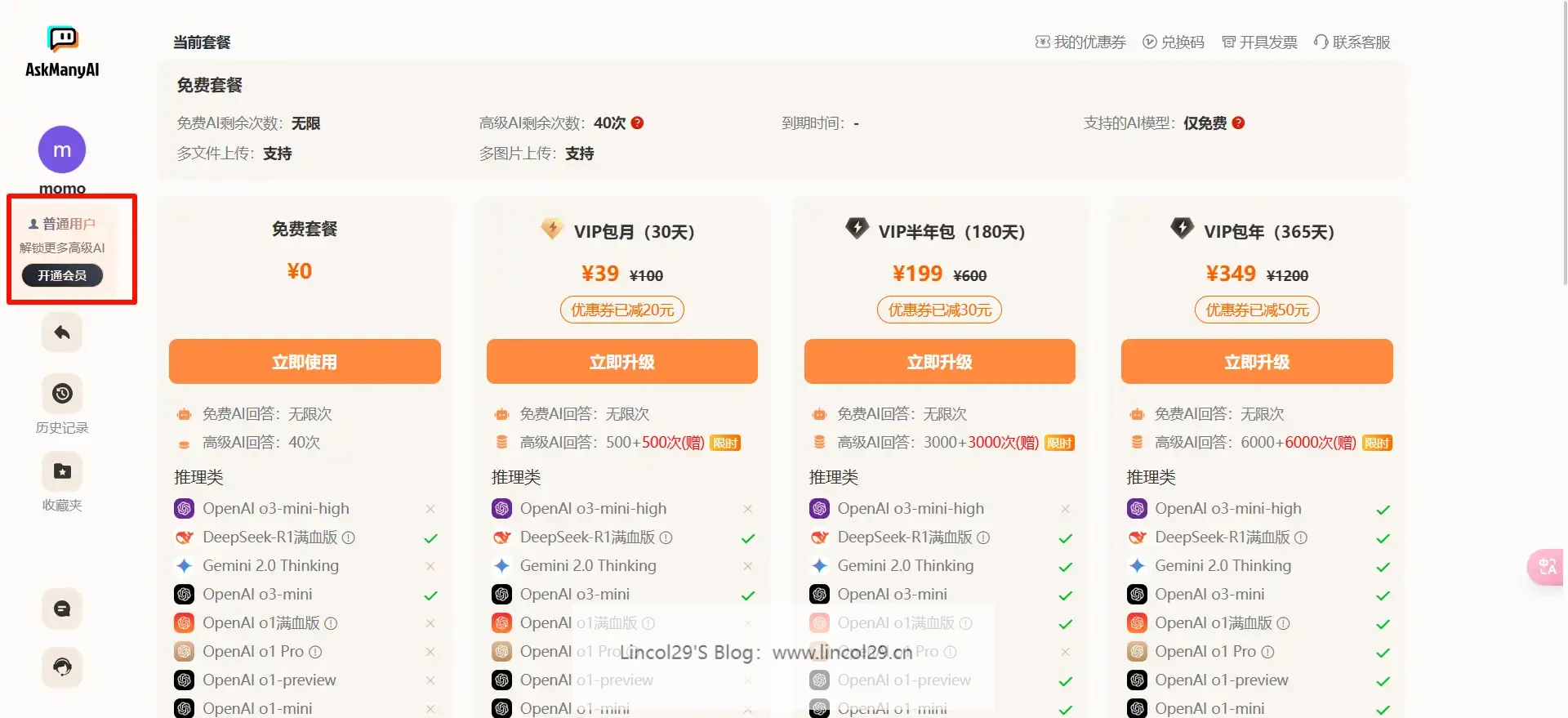

注册后直接使用满血版 DeepSeek R1,可以看到 AskManyAI可以对同一个问题调用多个大模型回答。

一问多答是这个 AskManyAI 产品的主打特色,用过之后就回不去用单个 AI 的产品了。

多个大模型共同回答问题,对比哪个回答对你更有帮助!

如果你想使用更高级的大模型,可以充值付费使用。

本地部署Deep Seek R1大模型

如果你想使用自己的机器本地部署Deep Seek R1大模型,本地部署后,你就拥有了一个完全属于自己的AI助手 – 响应飞快,永不排队,完全离线。最重要的是,它依然完全免费。lincol 将教你如何在本地部署,可以使用服务器(VPS)、NAS或吃灰的电脑。

安装 Ollama 框架

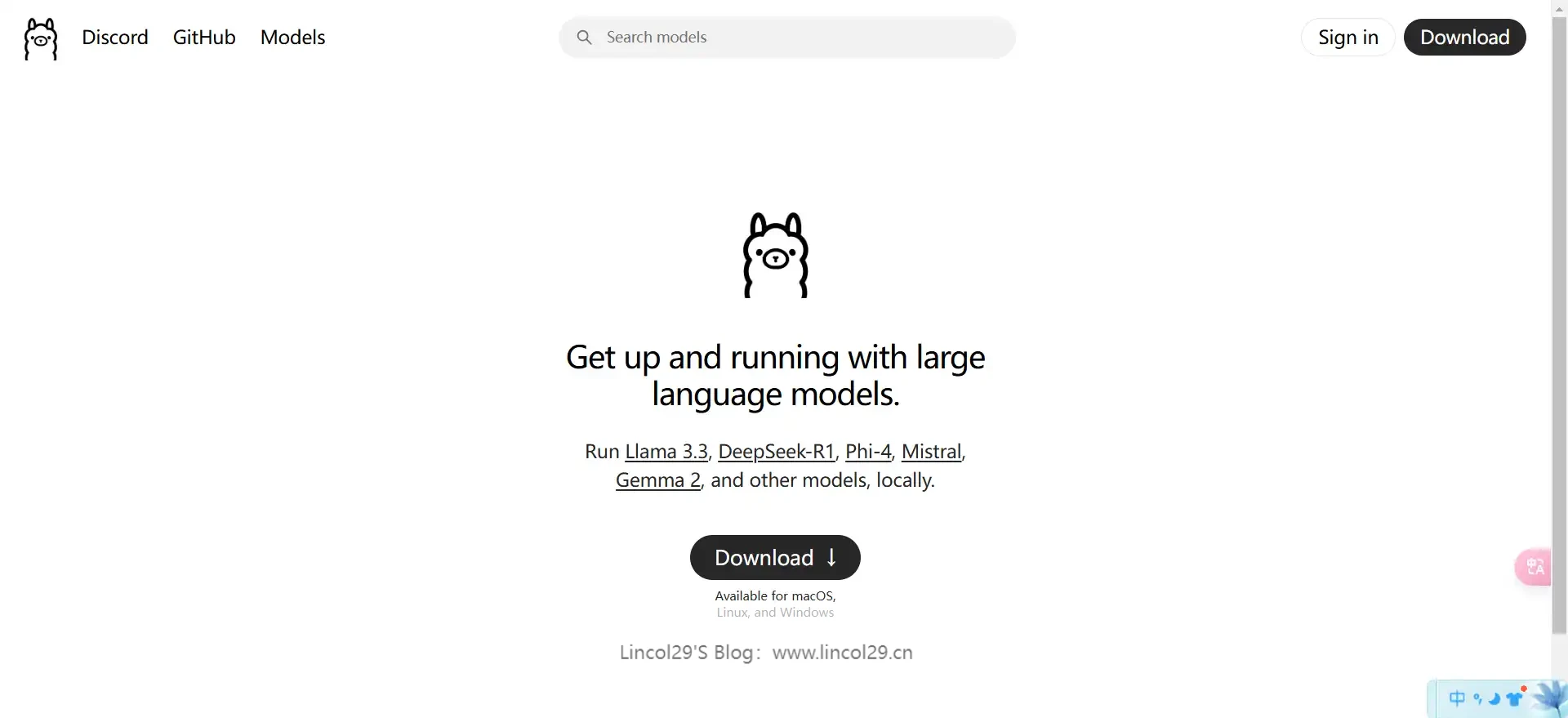

Ollama是什么?Ollama官网下载:Ollama框架下载

Ollama 是一个开源框架,旨在让用户能够更加便捷地使用和部署各种大型语言模型(LLMs, Large Language Models)。它的设计目标是提供一个简易、高效且易于集成的方式来使用这些复杂的语言模型,特别是对于那些需要在本地或特定环境下运行的应用场景。

进入 Ollam官网,点击 Download安装即可

下载Deep Seek R1模型

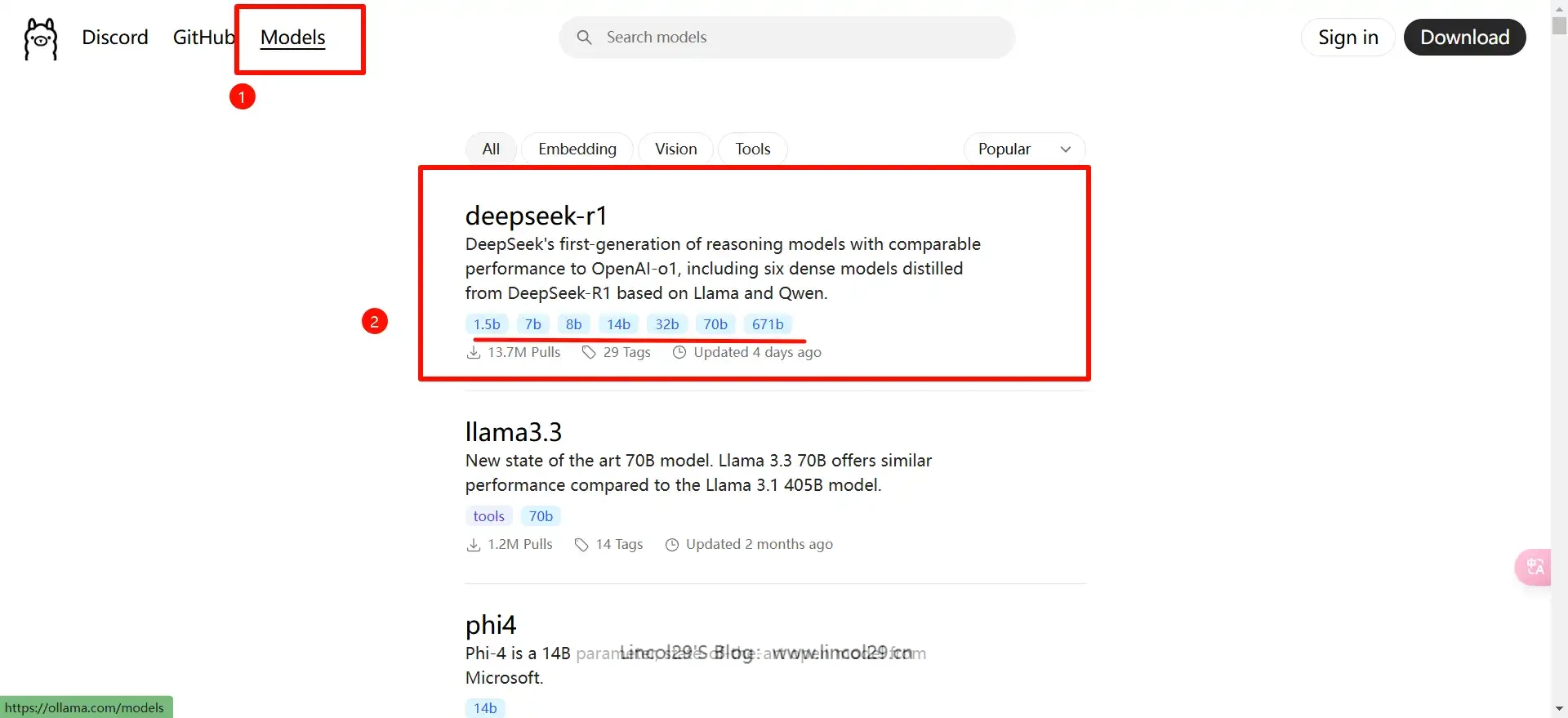

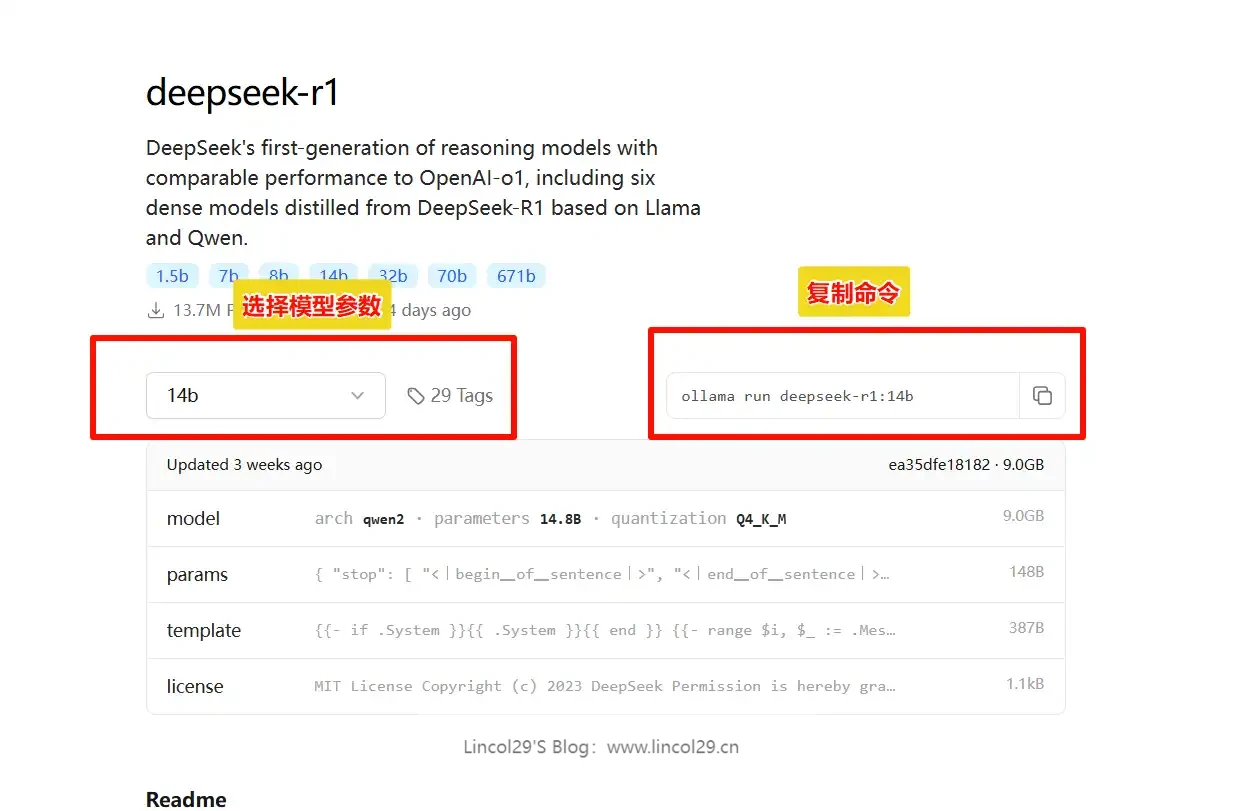

点击 Model——搜索DeepSeek-R1,选择对应的大模型参数下载

– 7b 大小的模型通常至少需要 8GB RAM

– 13b 大小的模型通常至少需要 16GB RAM

– 33b 大小的模型通常至少需要 32GB RAM

– 70b 大小的模型通常需要至少 64GB RAM

这里可以选择模型大小,不指定的话默认是 7B

满血版指的是 671B 大模型

选择模型参数后,复制命令。到 Ollama的终端执行

拓展阅读

群晖NAS本地部署DeepSeek R1大模型:使用docker部署ollama框架,群晖本地部署使用deep seek R1

正好需要,感谢分享!

自己造轮子太麻烦了 但为了尝鲜也是值得的 毕竟好东西大家都在用 谁不心动呢

我现在已经抛弃4o-mini啦,R1真好用。

这个套餐计划怎么说呢,我个人来说还是喜欢按token计算的API调用然后搭配上自己喜欢的客户端

这个R1主打免费吧,要使用token可以去看下我的nextchat那篇,推荐了uniapi。非常稳定好用。

R1的话目前有Azure和GitHub可以免费调用OpenRouter也有